بناء على نموذج سابق يسمى UniGen، فريق من باحثون من شركة أبل تعرض UniGen 1.5، وهو نظام يمكنه التعامل مع فهم الصور وإنشاءها وتحريرها ضمن نموذج واحد. وهنا التفاصيل.

بناء على UniGen الأصلي

وفي شهر مايو الماضي، نشر فريق من الباحثين في شركة أبل دراسة بعنوان UniGen: استراتيجيات التدريب المعززة ووقت الاختبار من أجل فهم وتوليد موحد متعدد الوسائط.

في هذا العمل، قدموا نموذجًا موحدًا للغة كبيرة متعدد الوسائط قادرًا على فهم الصور وتوليدها ضمن نظام واحد، بدلاً من الاعتماد على نماذج منفصلة لكل مهمة.

والآن، نشرت شركة أبل متابعة لهذه الدراسة، في ورقة بحثية بعنوان UniGen-1.5: تعزيز إنشاء الصور وتحريرها من خلال توحيد المكافآت في التعلم المعزز.

وأوضح UniGen-1.5

يعمل هذا البحث الجديد على توسيع نطاق UniGen من خلال إضافة إمكانات تحرير الصور إلى النموذج، ضمن إطار عمل واحد موحد، بدلاً من تقسيم الفهم والتوليد والتحرير عبر أنظمة مختلفة.

يعد توحيد هذه القدرات في نظام واحد أمرًا صعبًا لأن فهم الصور وإنشاءها يتطلب أساليب مختلفة. ومع ذلك، يرى الباحثون أن النموذج الموحد يمكنه الاستفادة من قدرته على الفهم لتحسين أداء التوليد.

ووفقًا لهم، فإن أحد التحديات الرئيسية في تحرير الصور هو أن النماذج غالبًا ما تكافح من أجل فهم تعليمات التحرير المعقدة بشكل كامل، خاصة عندما تكون التغييرات دقيقة أو محددة للغاية.

لمعالجة هذه المشكلة، يقدم UniGen-1.5 خطوة جديدة بعد التدريب تسمى “تحرير محاذاة التعليمات”:

“علاوة على ذلك، نلاحظ أن النموذج لا يزال غير مناسب في التعامل مع سيناريوهات التحرير المتنوعة بعد الضبط الدقيق تحت الإشراف بسبب عدم فهمه الكافي لتعليمات التحرير. لذلك، نقترح محاذاة تعليمات التحرير كمرحلة خفيفة بعد SFT لتعزيز المحاذاة بين تعليمات التحرير ودلالات الصورة المستهدفة. على وجه التحديد، يأخذ الصورة الشرطية والتعليمات كمدخلات ويتم تحسينها للتنبؤ بالمحتوى الدلالي للصورة المستهدفة عبر الأوصاف النصية. تشير النتائج التجريبية إلى ذلك هذه المرحلة مفيدة للغاية لتعزيز أداء التحرير.

بمعنى آخر، قبل مطالبة النموذج بتحسين مخرجاته من خلال التعلم المعزز (الذي يدرب النموذج من خلال مكافأة المخرجات الأفضل ومعاقبة المخرجات الأسوأ)، يقوم الباحثون أولاً بتدريبه على استنتاج وصف نصي مفصل لما يجب أن تحتويه الصورة المحررة، بناءً على الصورة الأصلية وتعليمات التحرير.

تساعد هذه الخطوة المتوسطة النموذج على استيعاب التعديل المقصود بشكل أفضل قبل إنشاء الصورة النهائية.

يستخدم الباحثون بعد ذلك التعلم المعزز بطريقة يمكن القول إنها أهم مساهمة في الورقة: فهم يستخدمون نفس نظام المكافأة لكل من إنشاء الصور وتحريرها، وهو الأمر الذي كان يمثل تحديًا في السابق لأن التعديلات يمكن أن تتراوح من تعديلات طفيفة إلى تحويلات كاملة.

ونتيجة لذلك، عند اختباره على العديد من معايير الصناعة التي تقيس مدى نجاح النماذج في اتباع التعليمات، والحفاظ على الجودة المرئية، والتعامل مع التعديلات المعقدة، فإن UniGen-1.5 إما يطابق أو يتفوق على العديد من نماذج اللغات الكبيرة متعددة الوسائط المفتوحة والمملوكة ملكية خاصة:

من خلال الجهود المذكورة أعلاه، يوفر UniGen-1.5 خط أساس أقوى لتطوير الأبحاث حول MLLMs الموحدة ويؤسس أداءً تنافسيًا عبر معايير فهم الصور وتوليدها وتحريرها. تظهر النتائج التجريبية أن UniGen-1.5 حصل على 0.89 و86.83 على GenEval وDPG-Bench، متفوقًا بشكل كبير على الأساليب الحديثة مثل BAGEL وBLIP3o. بالنسبة لتحرير الصور، حقق UniGen-1.5 مجموع نقاط 4.31 على ImgEdit، متجاوزًا النماذج الحديثة مفتوحة المصدر مثل OminiGen2 ويمكن مقارنته بالنماذج المسجلة الملكية مثل GPT-Image-1.

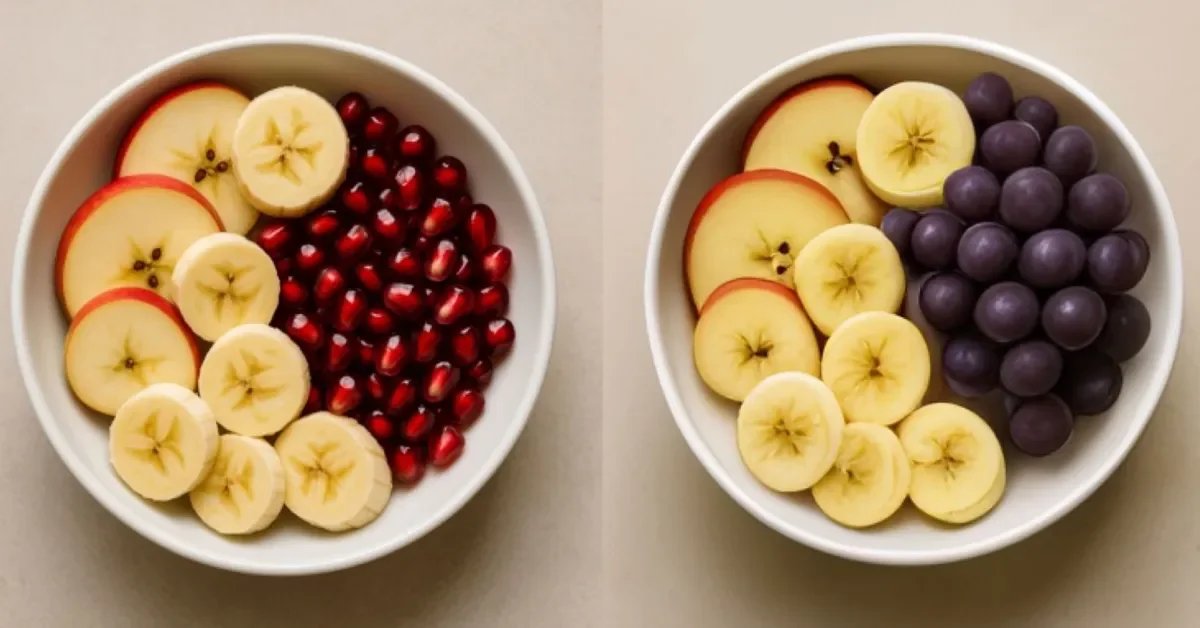

فيما يلي بعض الأمثلة على إنشاء تحويل النص إلى صورة وإمكانيات تحرير الصور في UniGen-1.5 (للأسف، يبدو أن الباحثين قاموا عن طريق الخطأ بقص المطالبات الخاصة بقطاع تحويل النص إلى صورة في الصورة الأولى):

لاحظ الباحثون أن UniGen-1.5 يواجه صعوبة في إنشاء النص، وكذلك مع اتساق الهوية في ظل ظروف معينة:

يتم توضيح حالات فشل UniGen-1.5 في كل من مهام إنشاء النص إلى صورة وتحرير الصور في الشكل (أ). في الصف الأول، نقدم الحالات التي يفشل فيها UniGen-1.5 في عرض أحرف النص بدقة، حيث يكافح جهاز إزالة الرموز المنفصل خفيف الوزن للتحكم في التفاصيل الهيكلية الدقيقة المطلوبة لإنشاء النص. في الصف الثاني، نعرض مثالين لتحولات الهوية المرئية التي أبرزتها الدائرة، على سبيل المثال، التغييرات في نسيج وشكل فراء وجه القطة، والاختلافات في لون ريشة الطائر. يحتاج UniGen-1.5 إلى مزيد من التحسين لمعالجة هذه القيود.

يمكنك العثور على الدراسة كاملة هنا.

عروض الإكسسوارات على أمازون

FTC: نحن نستخدم الروابط التابعة التلقائية لكسب الدخل. أكثر.

تنويه من موقعنا

تم جلب هذا المحتوى بشكل آلي من المصدر:

yalebnan.org

بتاريخ: 2025-12-18 22:37:00.

الآراء والمعلومات الواردة في هذا المقال لا تعبر بالضرورة عن رأي موقعنا والمسؤولية الكاملة تقع على عاتق المصدر الأصلي.

ملاحظة: قد يتم استخدام الترجمة الآلية في بعض الأحيان لتوفير هذا المحتوى.